在本地部署大语言模型

注:在本地部署大语言模型,通常需要较好的计算机性能,例如大于4核心的CPU,大于16GB的内存,大于8GB的显卡,如果没有独立显卡,可以选择1b参数的小模型,但是小模型可能效果不佳,在本地部署大语言模型之前,请先确保已经正确的安装了显卡驱动。

我们使用较为简单的ollama来本地部署大语言模型,ollama官方网站:

https://ollama.com/

1)下载ollama软件包

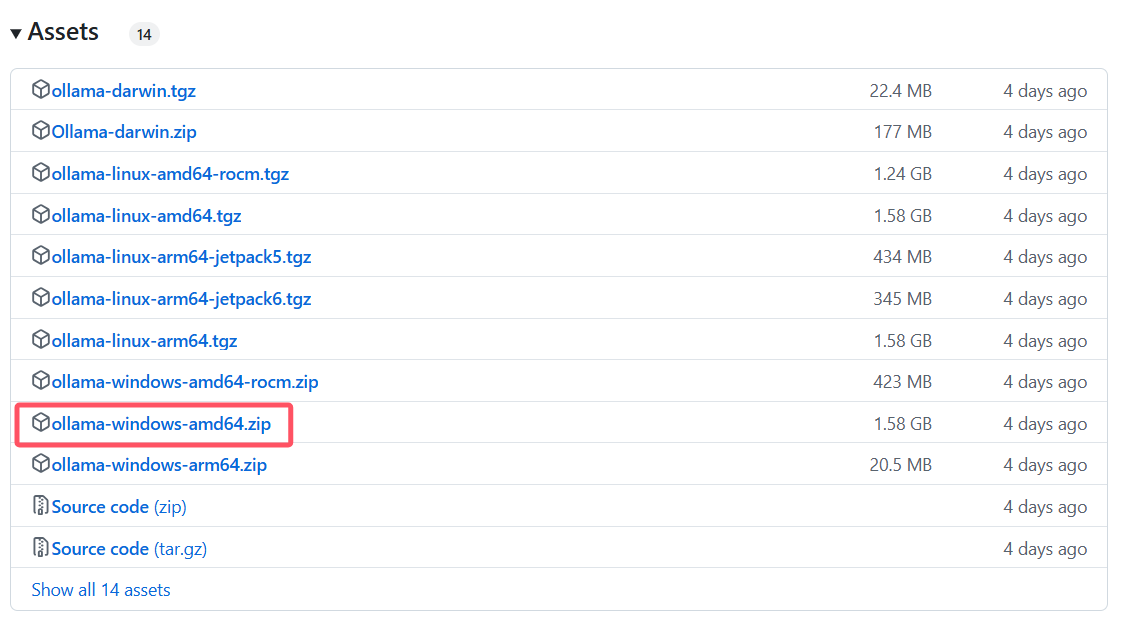

在ollama的官方Github仓库下载ollama压缩包,该压缩包无需安装,解压即可使用:

https://github.com/ollama/ollama/releases/

根据操作系统,选择下载对应的压缩包,如64位,Windows,Nvidia显卡,选择如下压缩包

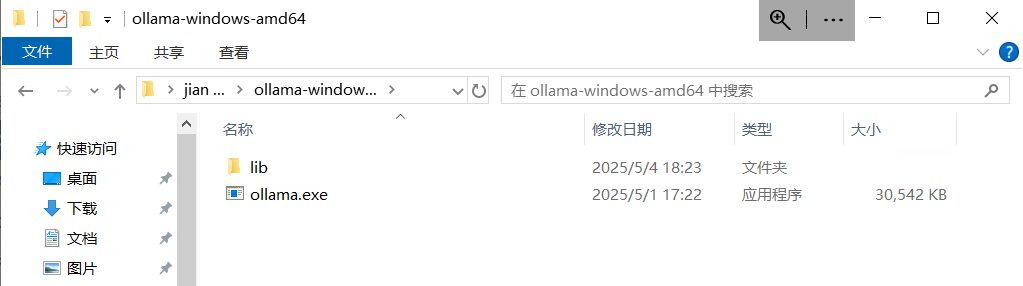

2)将压缩包解压,如图所示:

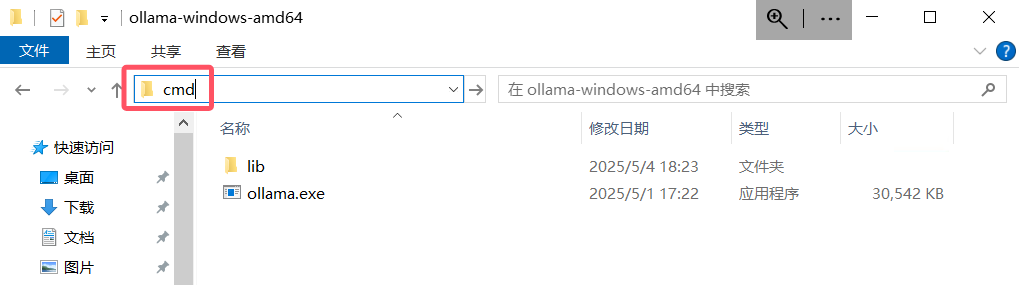

3)运行ollama程序

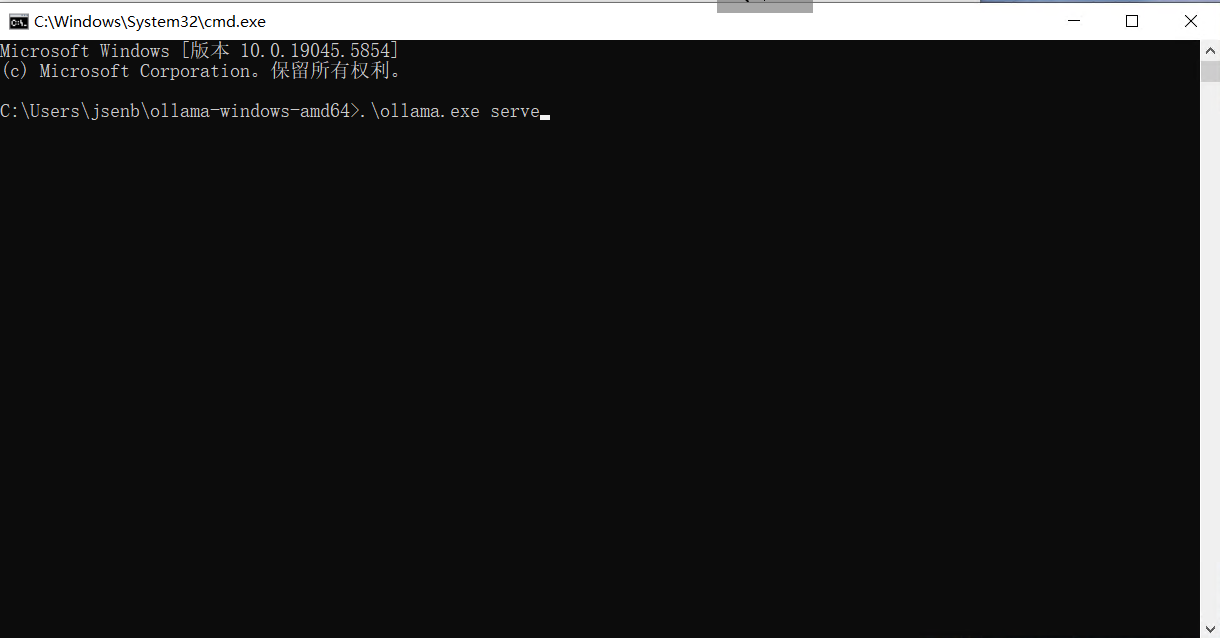

在ollama程序所在的路径,输入cmd,然后回车,即可打开该路径的命令行终端,如图:

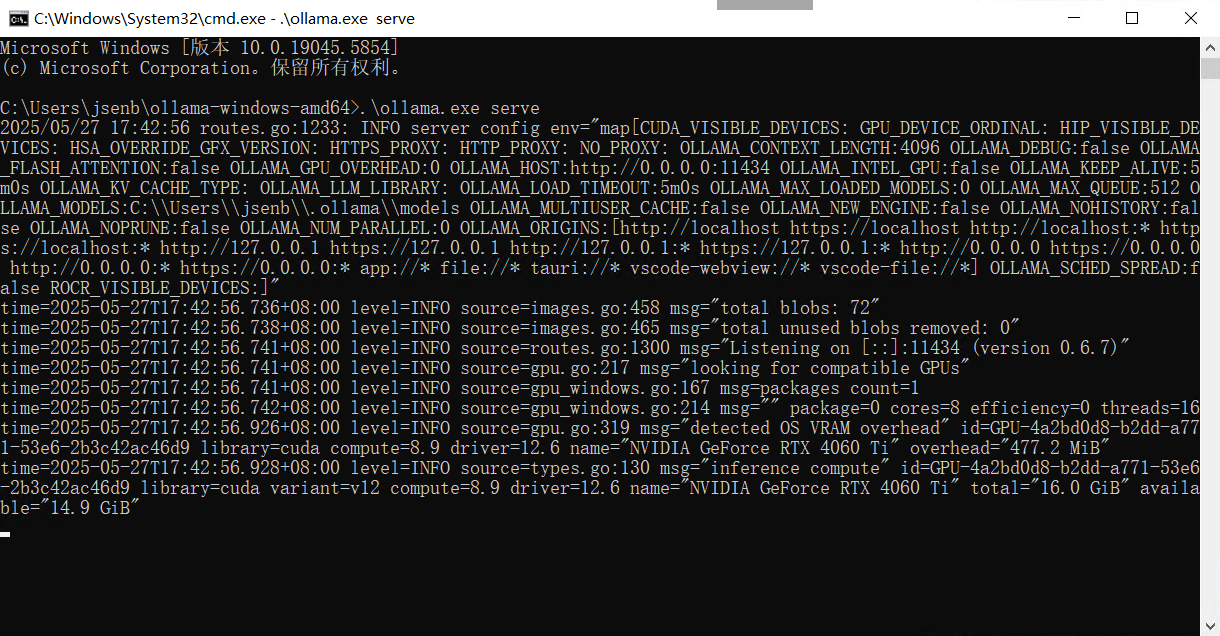

然后输入:.\ollama.exe serve,即可启动ollama,如图所示:

4)选择并运行大语言模型

之前运行ollama重新的窗口不要关闭。

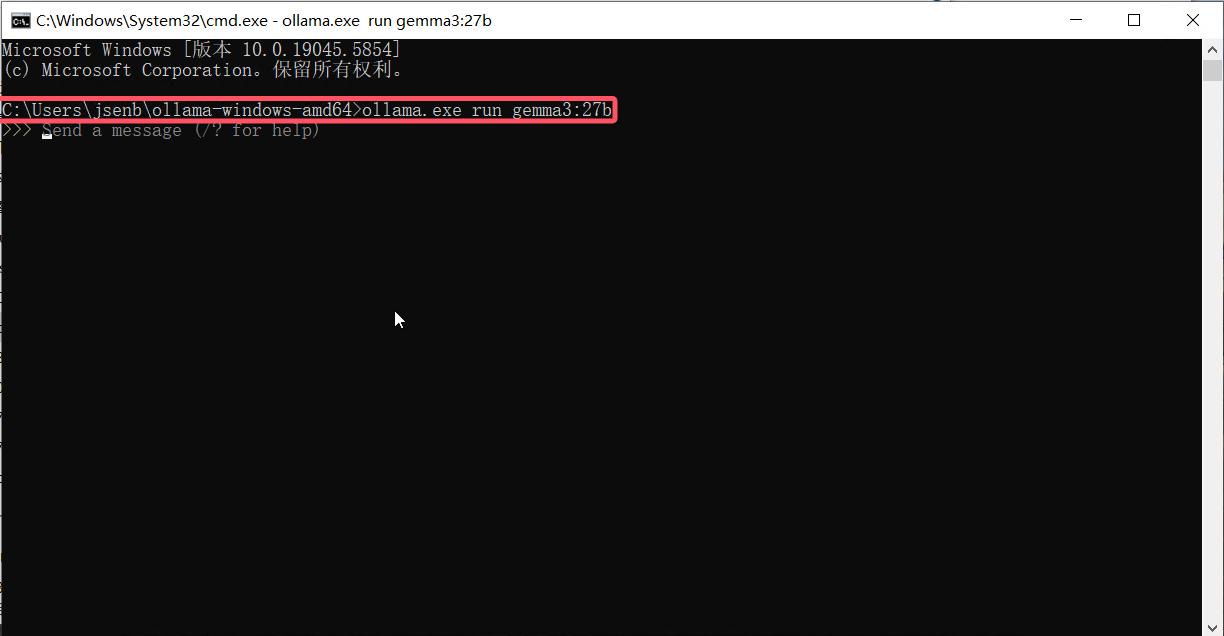

在ollama程序所在的路径,输入cmd,然后回车,重新打开另一个该路径的命令行终端,如图:

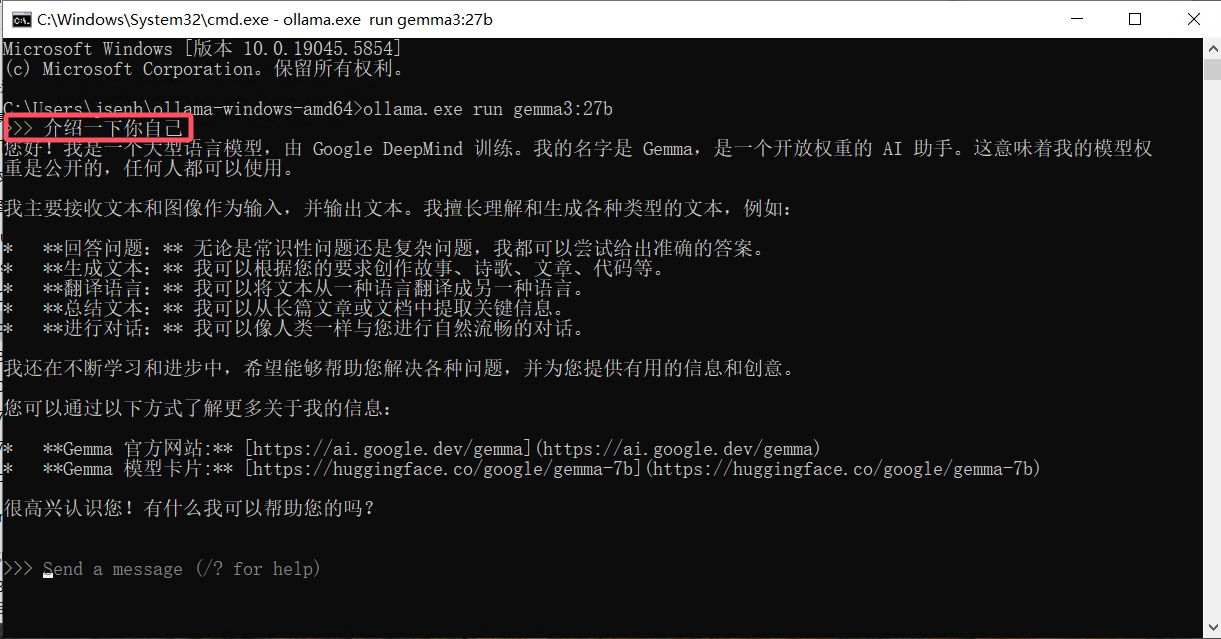

这时会出现提示符,只需要输入问题,并按回车即可与大语言模型进行对话,如图所示:

然后使用命令启动大语言模型,例如:.\ollama run gemma3:1b

即运行gemma3模型,1b参数版,如果是首次运行该模型,ollama会自动下载该模型。

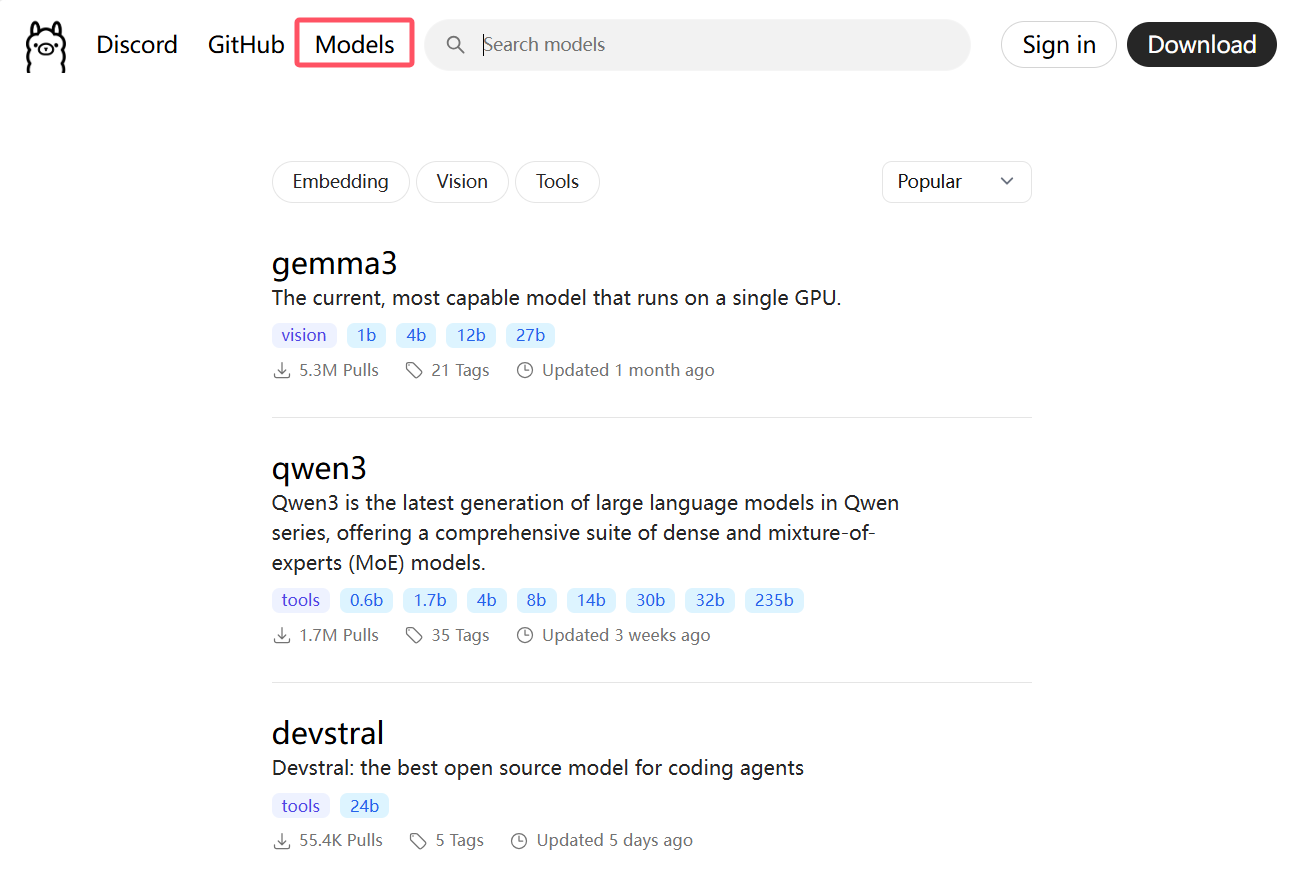

ollama支持的模型列表,可以在起网站上查看:

(可选)5)给本地大语言模型添加一个界面

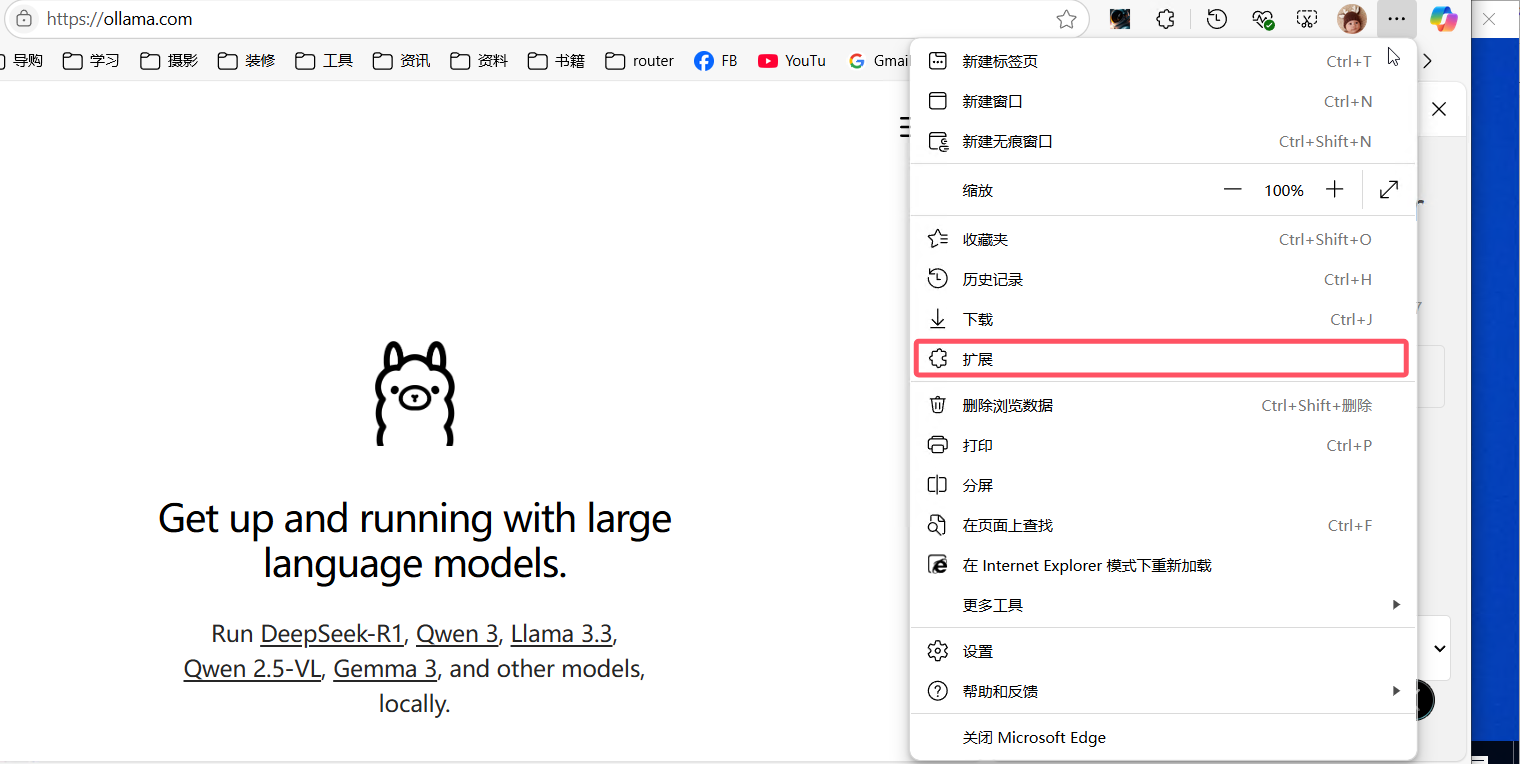

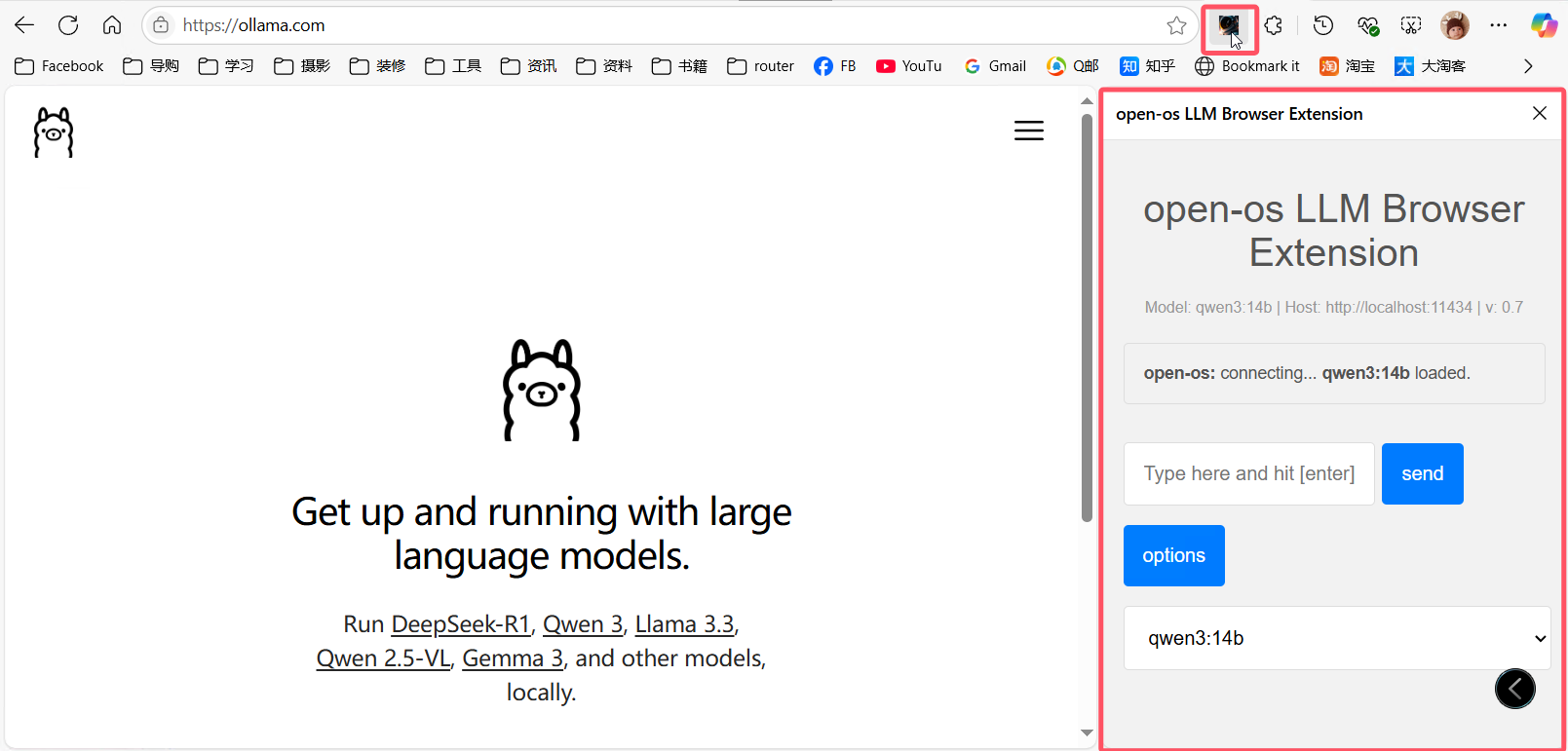

命令行使用大语言模型可能不够直观。我们可以通过安装一个前端界面来改善体验,例如使用浏览器扩展,为大语言模型提供一个用户界面 (UI)。

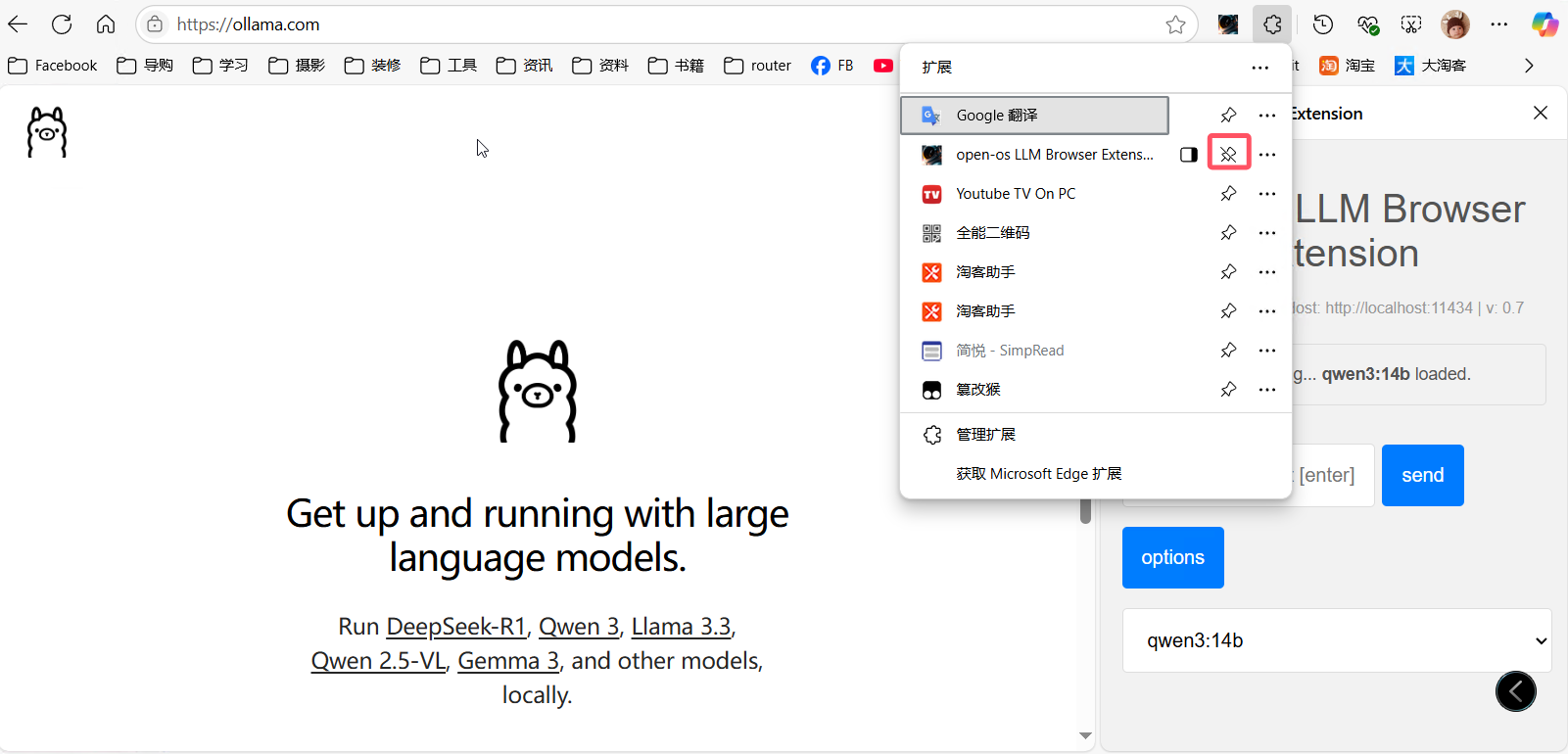

在微软Edge浏览器商店,安装拓展:open-os LLM Browser Extension;地址如下:

https://microsoftedge.microsoft.com/addons/detail/openos-llm-browser-exten/ofdjffhigloincakaabmanlemckeifeb

安装完成后,将该拓展固定到浏览器工具栏:

然后我们就可以在浏览器的侧边栏中,使用大语言模型:

除了浏览器拓展之后,我们还可以使用其他前端界面,例如:open-webui,Chatbox等等,大家可以自行搜索安装。